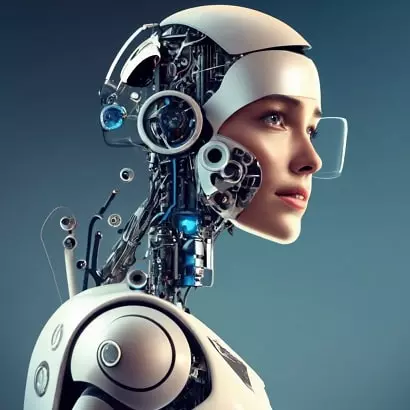

L’IA GPT-3 : Une Capacité de Raisonnement Comparable à Celle des Étudiants Universitaires ? Des Psychologues se Posent des Questions

Émergence du raisonnement analogique dans les grands modèles de langage

Une étude récente, réalisée par des psychologues universitaires, a révélé que le modèle de langage d’intelligence artificielle GPT-3 obtient des résultats similaires à ceux des étudiants universitaires lorsqu’il s’agit de résoudre des problèmes de raisonnement logique similaires à ceux des tests standardisés. Cette découverte suscite des interrogations quant à savoir si cette technologie imite le raisonnement humain ou si elle fait appel à un processus cognitif fondamentalement différent. Malheureusement, l’accès au logiciel sous-jacent de GPT-3 et à d’autres logiciels d’intelligence artificielle est actuellement limité, ce qui empêche une analyse approfondie de son fonctionnement.

Raisonnement Analogique : Une Capacité Humaine Traditionnelle

L’être humain est capable de résoudre de nouveaux problèmes sans formation préalable en les comparant à des problèmes familiers et en étendant les solutions à de nouvelles situations. Cette capacité, appelée raisonnement analogique, a longtemps été considérée comme propre à l’humain.

Cependant, les dernières avancées dans le domaine de l’intelligence artificielle remettent en question cette idée.

Une étude menée par des psychologues a démontré que GPT-3, un modèle de langage d’intelligence artificielle, se comporte de manière impressionnante, presque au niveau des étudiants universitaires, lorsqu’il est confronté à des problèmes de raisonnement similaires à ceux des tests d’intelligence standardisés, tels que le SAT. Toutefois, les chercheurs se demandent si GPT-3 imite le raisonnement humain en raison de son entraînement massif en langage ou s’il repose sur un nouveau type de processus cognitif. Cette question reste sans réponse en raison des limitations d’accès aux détails internes de GPT-3, qui sont protégés par l’entreprise qui l’a développé.

Les résultats de cette étude montrent que, bien que GPT-3 excelle dans certaines tâches de raisonnement, il échoue de manière spectaculaire dans d’autres. Par exemple, il peut réussir des problèmes analogiques, mais il est incapable d’accomplir des tâches simples pour les humains, telles que l’utilisation d’outils pour résoudre des problèmes physiques.

L’étude a également comparé les performances de GPT-3 à celles des étudiants universitaires sur des questions analogiques et de raisonnement. Les résultats ont montré que GPT-3 a résolu 80 % des problèmes correctement, un score bien au-dessus de la moyenne des étudiants humains, bien que certains problèmes aient posé des défis à l’IA.

Les chercheurs espèrent comprendre si GPT-3 reproduit véritablement le raisonnement humain ou s’il utilise une méthode totalement nouvelle qui imite simplement la pensée humaine. Cependant, pour y parvenir, ils devront obtenir un accès plus approfondi aux détails internes du modèle, ainsi qu’aux données d’entraînement, et réaliser des tests spécifiques pour évaluer ses capacités cognitives.

Sources :

Webb, T., Holyoak, K.J. & Lu, H. Emergent analogical reasoning in large language models. Nat Hum Behav, 2023 https://www.nature.com/articles/s41562-023-01659-w

Rémi Abida

Psychologue à Rennes

26 rue Poullain Duparc

35000 Rennes

07 56 85 87 08